|

|

| Software version |

3.0+ |

| Operating System |

Debian 7 |

| Website |

Puppet Website |

| Last Update |

02/08/2013 |

| Others |

Clients OS:

Debian 6/7

Solaris 10

RHEL 6 |

1 Introduction

Puppet est une application très pratique… C’est ce que l’on pourrait retrouver dans les entreprises avec de grands volumes de serveurs, où le système d’information est « industrialisé ».

Puppet permet d’automatiser un grand nombre de tache d’administration, comme l’installation de logiciels, de services ou encore de modifier des fichiers.

Puppet permet de faire cela de manière centralisée ce qui permet d’administrer et de mieux contrôler un grand nombre de serveur hétérogènes ou homogènes.

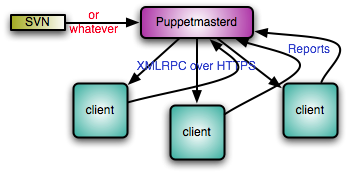

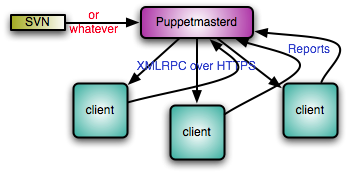

Puppet fonctionne en mode Client / Serveur.

Sur chaque machine un client va être installé et c’est lui qui va contacter le PuppetMaster, le serveur, par le biais de communication HTTPS, et donc SSL, un système pki est fourni.

Puppet a été développé en Ruby le rendant multiplateforme : bsd (free, macos …) ,linux (redhat, debian, suse …), sun (opensolaris …)

Reductive Labs, la société éditant Puppet, a développé un produit complémentaire, nommé Facter.

Cette application permet de lister des éléments propres aux systèmes administrés, comme le nom de machine, l’adresse ip, la distribution, des variables d’environnement utilisables dans les templates de puppet.

Puppet gérant des templates, on peut rapidement comprendre l’utilité de Facter, si par exemple on gère une ferme de serveurs de messagerie, qui nécessite un paramétrage contenant par exemple le nom de la machine. Là un template combiné avec des variables d’environnements s’avère tout à fait utile.

Enfin bref Puppet combiné à Facter me semble une solution très intéressante pour simplifier l’administration de systèmes.

Voici un schéma de fonctionnement de puppet :

Pour la configuration de Puppet, si vous souhaitez utiliser un IDE, il existe Geppetto. Je vous le recommande d'ailleurs, ça vous évitera bien des soucis de syntaxe.

Les documentations pour des version antérieurs à ce celle ci sont disponible ici :

2 Hiérarchie de Puppet

Avant d'aller plus loin, j'ai pompé depuis le site officiel le fonctionnement de l'arborescence de puppet :

All Puppet data files (modules, manifests, distributable files, etc) should be maintained in a Subversion or CVS repository (or your favorite Version Control System). The following hierarchy describes the layout one should use to arrange the files in a maintainable fashion:

- /manifests/: this directory contains files and subdirectories that determine the manifest of individual systems but do not logically belong to any particular module. Generally, this directory is fairly thin and alternatives such as the use of LDAP or other external node tools can make the directory even thinner. This directory contains the following special files:

- site.pp: first file that the Puppet Master parses when determining a server's catalog. It imports all the underlying subdirectories and the other special files in this directory. It also defines any global defaults, such as package managers. See sample site.pp.

- templates.pp: defines all template classes. See also terminology:template classes. See sample templates.pp.

- nodes.pp: defines all the nodes if not using an external node tool. See sample nodes.pp.

- /modules/{modulename}/: houses puppet modules in subdirectories with names matching that of the module name. This area defines the general building blocks of a server and contains modules such as for openssh, which will generally define classes openssh::client and openssh::server to setup the client and server respectively. The individual module directories contains subdirectories for manifests, distributable files, and templates. See `modules organization, terminology:module.

- /modules/user/: A special module that contains manifests for users. This module contains a special subclass called user::virtual which declares all the users that might be on a given system in a virtual way. The other subclasses in the user module are classes for logical groupings, such as user::unixadmins, which will realize the individual users to be included in that group. See also naming conventions, terminology:realize.

- /services/ : this is an additional modules area that is specified in the module path for the puppetmaster. However, instead of generic modules for individual services and bits of a server, this module area is used to model servers specific to enterprise level infrastructure services (core infrastructure services that your IT department provides, such as www, enterprise directory, file server, etc). Generally, these classes will include the modules out of /modules/ needed as part of the catalog (such as openssh::server, postfix, user::unixadmins, etc). The files section for these modules is used to distribute configuration files specific to the enterprise infrastructure service such as openldap schema files if the module were for the enterprise directory. To avoid namespace collision with the general modules, it is recommended that these modules/classes are prefixed with s_ (e.g. s_ldap for the enterprise directory server module)

- /clients/: similar to the /services/ module area, this area is used for modules related to modeling servers for external clients (departments outside your IT department). To avoid namespace collision, it is recommended that these modules/classes are prefixed with c_.

- /notes/: this directory contains notes for reference by local administrators.

- /plugins/: contains custom types programmed in Ruby. See also terminology:plugin-type.

- /tools/: contains scripts useful to the maintenance of Puppet.

3 Installation

3.1 Serveur Puppet

La version utilisée du master doit être la même que celle des postes clients. Il est très fortement recommandé d'utiliser une version supérieure ou égale à 0.25.4 (correctif de nombreux problèmes de performance).

Pour cela, sur Debian, il faudra installer la version disponible en squeeze/lenny-backport ou supérieur, et la bloquer pour éviter qu'une upgrade malencontreuse ne change sa version (utilisation des "pin locks"). Nous allons opter ici pour la version donnée sur le site officiel de Puppet.

Pour le moment,il faut configurer le fichier /etc/hosts avec l'ip du serveur :

/etc/hosts /etc/hosts

|

...

192.168.0.93 puppet-prd.deimos.fr puppet

...

|

Note : Vérifiez que l'horloge du puppetmaster (et les client aussi bien sûr) est bien à jour/synchronisée. Il peut y avoir un problème avec les certificats qui seront non reconnus/acceptés si il y a un décalage (faire un `dpkg-reconfigure tz-data`).

Configurez le repository officiel de puppet si vous souhaitez la dernière version, sinon sautez cette étape pour installer la version qui est fournit par votre distribution :

|

wget http://apt.puppetlabs.com/puppetlabs-release-stable.deb

dpkg -i puppetlabs-release-stable.deb |

Et ensuite, nous mettez à jour :

aptitude aptitude

|

|

|

Puis installer puppetmaster :

aptitude aptitude

|

aptitude install puppetmaster

|

On peut vérifier que puppetmaster est bien installé en lançant 'facter' (voir si elle retourne bien quelque chose) ou la présence des fichiers SSL (dans /var/lib/puppet).

3.2 Serveur Web

Il va maintenant falloir configurer un serveur web sur la même machine que le serveur Puppet (Puppet Master). Pourquoi ? Tout simplement par ce que le serveur par défaut est Webrick et que celui ci s'écroule si 10 noeuds en simultané y accèdent.

WARNING WARNING

|

| Vous pouvez garder Webrick si vous souhaitez faire du test sur quelque noeuds, mais pas pour un passage en production !

|

Je vous laisse le choix ici entre Passenger et Nginx. Passenger est la solution recommandée depuis la version 3 de Puppet.

3.2.1 Passenger

Si vous avez fait le choix d'utiliser Passenger comme il est recommandé par PuppetLab, il va falloir désactiver le démarrage automatique du démon, puisque celui ci démarrera un serveur web et entrera en conflit avec Passenger si on le laisse :

/etc/default/puppetmaster /etc/default/puppetmaster

|

# Defaults for puppetmaster - sourced by /etc/init.d/puppetmaster

# Start puppetmaster on boot? If you are using passenger, you should

# have this set to "no"

START=no

# Startup options

DAEMON_OPTS=""

# What port should the puppetmaster listen on (default: 8140).

PORT=8140 |

Désactivez maintenant le service :

|

/etc/init.d/puppetmaster stop |

Puis, installez Passenger :

aptitude aptitude

|

aptitude install puppetmaster-passenger |

Vous n'avez pas de configuration à faire. Tout est prévu par les packages officiels de Puppet. Dans le cas ou vous l'avez installé sans le repository officiel, voici la configuration générée :

/etc/apache2/sites-enabled/puppetmaster /etc/apache2/sites-enabled/puppetmaster

|

# you probably want to tune these settings

PassengerHighPerformance on

PassengerMaxPoolSize 12

PassengerPoolIdleTime 1500

# PassengerMaxRequests 1000

PassengerStatThrottleRate 120

RackAutoDetect Off

RailsAutoDetect Off

Listen 8140

<VirtualHost *:8140>

SSLEngine on

SSLProtocol -ALL +SSLv3 +TLSv1

SSLCipherSuite ALL:!ADH:RC4+RSA:+HIGH:+MEDIUM:-LOW:-SSLv2:-EXP

SSLCertificateFile /var/lib/puppet/ssl/certs/puppet.deimos.lan.pem

SSLCertificateKeyFile /var/lib/puppet/ssl/private_keys/puppet.deimos.lan.pem

SSLCertificateChainFile /var/lib/puppet/ssl/certs/ca.pem

SSLCACertificateFile /var/lib/puppet/ssl/certs/ca.pem

# If Apache complains about invalid signatures on the CRL, you can try disabling

# CRL checking by commenting the next line, but this is not recommended.

SSLCARevocationFile /var/lib/puppet/ssl/ca/ca_crl.pem

SSLVerifyClient optional

SSLVerifyDepth 1

# The `ExportCertData` option is needed for agent certificate expiration warnings

SSLOptions +StdEnvVars +ExportCertData

# This header needs to be set if using a loadbalancer or proxy

RequestHeader unset X-Forwarded-For

RequestHeader set X-SSL-Subject %{SSL_CLIENT_S_DN}e

RequestHeader set X-Client-DN %{SSL_CLIENT_S_DN}e

RequestHeader set X-Client-Verify %{SSL_CLIENT_VERIFY}e

DocumentRoot /usr/share/puppet/rack/puppetmasterd/public/

RackBaseURI /

<Directory /usr/share/puppet/rack/puppetmasterd/>

Options None

AllowOverride None

Order allow,deny

allow from all

</Directory>

</VirtualHost> |

3.2.2 NGINX et Mongrel

3.2.2.1 Installation

Si vous avez fait le choix d'NGINX et Mongrel, il va falloir commencer par les installer :

aptitude aptitude

|

aptitude install nginx mongrel

|

3.2.2.2 Configuration

Modification du fichier /etc/default/puppetmaster :

/etc/default/puppetmaster /etc/default/puppetmaster

|

# Defaults for puppetmaster - sourced by /etc/init.d/puppet

# Start puppet on boot?

START=yes

# Startup options

DAEMON_OPTS=""

# What server type to run

# Options:

# webrick (default, cannot handle more than ~30 nodes)

# mongrel (scales better than webrick because you can run

# multiple processes if you are getting

# connection-reset or End-of-file errors, switch to

# mongrel. Requires front-end web-proxy such as

# apache, nginx, or pound)

# See: http://reductivelabs.com/trac/puppet/wiki/UsingMongrel

SERVERTYPE=mongrel

# How many puppetmaster instances to start? Its pointless to set this

# higher than 1 if you are not using mongrel.

PUPPETMASTERS=4

# What port should the puppetmaster listen on (default: 8140). If

# PUPPETMASTERS is set to a number greater than 1, then the port for

# the first puppetmaster will be set to the port listed below, and

# further instances will be incremented by one

#

# NOTE: if you are using mongrel, then you will need to have a

# front-end web-proxy (such as apache, nginx, pound) that takes

# incoming requests on the port your clients are connecting to

# (default is: 8140), and then passes them off to the mongrel

# processes. In this case it is recommended to run your web-proxy on

# port 8140 and change the below number to something else, such as

# 18140.

PORT=18140

|

Après (re-)lancement du démon, on doit pouvoir voir les sockets attachées :

netstat netstat

|

> netstat -pvltpn

Connexions Internet actives (seulement serveurs)

Proto Recv-Q Send-Q Adresse locale Adresse distante Etat PID/Program name

tcp 0 0 0.0.0.0:41736 0.0.0.0:* LISTEN 2029/rpc.statd

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 2018/portmap

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 2333/sshd

tcp 0 0 127.0.0.1:18140 0.0.0.0:* LISTEN 10059/ruby tcp 0 0 127.0.0.1:18141 0.0.0.0:* LISTEN 10082/ruby tcp 0 0 127.0.0.1:18142 0.0.0.0:* LISTEN 10104/ruby tcp 0 0 127.0.0.1:18143 0.0.0.0:* LISTEN 10126/ruby tcp6 0 0 :::22 :::* LISTEN 2333/sshd |

On ajoute les lignes suivante dans le fichier /etc/puppet/puppet.conf :

/etc/puppet/puppet.conf /etc/puppet/puppet.conf

|

[main]

logdir=/var/log/puppet

vardir=/var/lib/puppet

ssldir=/var/lib/puppet/ssl

rundir=/var/run/puppet

factpath=$vardir/lib/facter

templatedir=$confdir/templates

pluginsync = true [master]# These are needed when the puppetmaster is run by passenger# and can safely be removed if webrick is used.ssl_client_header = HTTP_X_SSL_SUBJECTssl_client_verify_header = SSL_CLIENT_VERIFYreport = true [agent]server=puppet-srv.deimos.fr |

On modifie la configuration suivante dans /etc/nginx.conf :

/etc/nginx/nginx.conf /etc/nginx/nginx.conf

|

user www-data;

worker_processes 4;

error_log /var/log/nginx/error.log;

pid /var/run/nginx.pid;

events {

worker_connections 1024;

# multi_accept on;

}

http {

#include /etc/nginx/mime.types; default_type application/octet-stream;

access_log /var/log/nginx/access.log; sendfile on; tcp_nopush on;

# Look at TLB size in /proc/cpuinfo (Linux) for the 4k pagesize large_client_header_buffers 16 4k; proxy_buffers 128 4k;

#keepalive_timeout 0;

keepalive_timeout 65;

tcp_nodelay on;

gzip on;

gzip_disable "MSIE [1-6]\.(?!.*SV1)";

include /etc/nginx/conf.d/*.conf;

include /etc/nginx/sites-enabled/*;

} |

Et on ajoute cette configuration pour puppet :

/etc/nginx/sites-available/puppetmaster.conf /etc/nginx/sites-available/puppetmaster.conf

|

upstream puppet-prd.deimos.fr {

server 127.0.0.1:18140;

server 127.0.0.1:18141;

server 127.0.0.1:18142;

server 127.0.0.1:18143;

}

server {

listen 8140;

ssl on;

ssl_certificate /var/lib/puppet/ssl/certs/puppet-prd.pem; ssl_certificate_key /var/lib/puppet/ssl/private_keys/puppet-prd.pem; ssl_client_certificate /var/lib/puppet/ssl/ca/ca_crt.pem;

ssl_ciphers SSLv2:-LOW:-EXPORT:RC4+RSA;

ssl_session_cache shared:SSL:8m;

ssl_session_timeout 5m;

ssl_verify_client optional;

# obey to the Puppet CRL

ssl_crl /var/lib/puppet/ssl/ca/ca_crl.pem;

root /var/empty;

access_log /var/log/nginx/access-8140.log;

#rewrite_log /var/log/nginx/rewrite-8140.log;

# Variables

# $ssl_cipher returns the line of those utilized it is cipher for established SSL-connection

# $ssl_client_serial returns the series number of client certificate for established SSL-connection

# $ssl_client_s_dn returns line subject DN of client certificate for established SSL-connection

# $ssl_client_i_dn returns line issuer DN of client certificate for established SSL-connection

# $ssl_protocol returns the protocol of established SSL-connection

location / {

proxy_pass http://puppet-prd.deimos.fr; proxy_redirect off;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Client_DN $ssl_client_s_dn;

proxy_set_header X-Client-Verify $ssl_client_verify;

proxy_set_header X-SSL-Subject $ssl_client_s_dn;

proxy_set_header X-SSL-Issuer $ssl_client_i_dn;

proxy_read_timeout 65;

}

} |

Ensuite on créer le lien symbolique pour appliquer la configuration :

ln ln

|

cd /etc/nginx/sites-available

ln -s /etc/nginx/sites-enabled/puppetmaster .

|

Et ensuite on redémarre le serveur Nginx.

Pour vérifier que les daemons tournent correctement, vous devez avoir les sockets suivantes ouvertes :

netstat netstat

|

> netstat -vlptn

Connexions Internet actives (seulement serveurs)

Proto Recv-Q Send-Q Adresse locale Adresse distante Etat PID/Program name

tcp 0 0 0.0.0.0:41736 0.0.0.0:* LISTEN 2029/rpc.statd

tcp 0 0 0.0.0.0:8140 0.0.0.0:* LISTEN 10293/nginx tcp 0 0 0.0.0.0:8141 0.0.0.0:* LISTEN 10293/nginx

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 2018/portmap

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 2333/sshd

tcp 0 0 127.0.0.1:18140 0.0.0.0:* LISTEN 10059/ruby

tcp 0 0 127.0.0.1:18141 0.0.0.0:* LISTEN 10082/ruby

tcp 0 0 127.0.0.1:18142 0.0.0.0:* LISTEN 10104/ruby

tcp 0 0 127.0.0.1:18143 0.0.0.0:* LISTEN 10126/ruby

tcp6 0 0 :::22 :::* LISTEN 2333/sshd |

3.3 Clients Puppet

Pour les clients, c'est simple aussi. Mais avant ajoutez la ligne du serveur dans le fichier hosts :

/etc/hosts /etc/hosts

|

...

192.168.0.93 puppet-prd.deimos.fr puppet

|

Ceci n'est pas obligatoire si vos noms DNS sont correctement configurés.

3.3.1 Debian

Si vous souhaitez utiliser la dernière version :

|

wget http://apt.puppetlabs.com/puppetlabs-release-stable.deb

dpkg -i puppetlabs-release-stable.deb |

Et ensuite, nous mettez à jour :

aptitude aptitude

|

|

|

Vérifier que le fichier /etc/hosts contient bien le hostname de la machine cliente, puis installez puppet :

apt-get apt-get

|

aptitude install puppet

|

3.3.2 Red Hat

Tout comme Debian, il existe un repo yum sur Red Hat et nous allons installer un package qui va le configurer pour nous :

rpm rpm

|

rpm -ivh http://yum.puppetlabs.com/el/6/products/x86_64/puppetlabs-release-6-6.noarch.rpm |

Puis on installe :

yum yum

|

|

|

3.3.3 Solaris

Le client Puppet dans la version stable de blastwave est trop ancien (0.23). Il faudra donc installer Puppet (et Facter) par l'intermédiaire du gestionnaire standard de Ruby: gem.

Pour cela, il faudra au préalable installer ruby avec la commande suivante:

pkg-get pkg-get

|

pkg-get -i ruby

|

WARNING WARNING

|

|

Vérifier que rubygems n'est pas déjà installé, sinon le supprimer :

pkg-get pkg-get

|

pkg-get -r rubygems

|

|

puis installer une version plus à jour à partir des sources:

Installer puppet avec la commande et l'argument -p si vous avez un proxy :

Il faut modifier/ajouter quelques commandes qui ne sont pas par défaut sur Solaris, pour que Puppet fonctionne mieux:

- Créer un lien pour uname et puppetd :

ln ln

|

ln -s /usr/bin/uname /usr/bin/

ln -s /opt/csw/bin/puppetd /usr/bin/

|

- Créer un script appelé /usr/bin/dnsdomainname :

/usr/bin/dnsdomainname /usr/bin/dnsdomainname

|

#!/usr/bin/bash

DOMAIN="`/usr/bin/domainname 2> /dev/null`"

if [ ! -z "$DOMAIN" ]; then

echo $DOMAIN | sed 's/^[^.]*.//'

fi |

chmod chmod

|

chmod 755 /usr/bin/dnsdomainname

|

Ensuite, la procédure est la même que pour les autres OS, c'est à dire, modifier /etc/hosts pour inclure puppet-prd.deimos.fr, et lancer:

puppetd puppetd

|

puppetd --verbose --no-daemon --test --server puppet-prd.deimos.fr

|

A ce stade là, si ça ne fonctionne pas, c'est tout simplement qu'il faut modifier la configuration (puppet.conf) de votre client.

4 Configuration

4.1 Serveur

Pour la partie serveur, voici comment est constitué l'arborescence de celui ci (dans /etc/puppet) :

.

|-- auth.conf

|-- autosign.conf

|-- fileserver.conf

|-- manifests

| |-- common.pp

| |-- modules.pp

| `-- site.pp

|-- modules

|-- puppet.conf

`-- templates

4.1.1 auth.conf

C'est ici que nous allons régler toutes les autorisations :

/etc/puppet/auth.conf /etc/puppet/auth.conf

|

# This is an example auth.conf file, it mimics the puppetmasterd defaults

#

# The ACL are checked in order of appearance in this file.

#

# Supported syntax:

# This file supports two different syntax depending on how

# you want to express the ACL.

#

# Path syntax (the one used below):

# ---------------------------------

# path /path/to/resource

# [environment envlist]

# [method methodlist]

# [auth[enthicated] {yes|no|on|off|any}]

# allow [host|ip|*]

# deny [host|ip]

#

# The path is matched as a prefix. That is /file match at

# the same time /file_metadat and /file_content.

#

# Regex syntax:

# -------------

# This one is differenciated from the path one by a '~'

#

# path ~ regex

# [environment envlist]

# [method methodlist]

# [auth[enthicated] {yes|no|on|off|any}]

# allow [host|ip|*]

# deny [host|ip]

#

# The regex syntax is the same as ruby ones.

#

# Ex:

# path ~ .pp$

# will match every resource ending in .pp (manifests files for instance)

#

# path ~ ^/path/to/resource

# is essentially equivalent to path /path/to/resource

#

# environment:: restrict an ACL to a specific set of environments

# method:: restrict an ACL to a specific set of methods

# auth:: restrict an ACL to an authenticated or unauthenticated request

# the default when unspecified is to restrict the ACL to authenticated requests

# (ie exactly as if auth yes was present).

#

### Authenticated ACL - those applies only when the client

### has a valid certificate and is thus authenticated

# allow nodes to retrieve their own catalog (ie their configuration)

path ~ ^/catalog/([^/]+)$

method find

allow $1

# allow nodes to retrieve their own node definition

path ~ ^/node/([^/]+)$

method find

allow $1

# allow all nodes to access the certificates services

path /certificate_revocation_list/ca

method find

allow *

# allow all nodes to store their reports

path /report

method save

allow *

# inconditionnally allow access to all files services

# which means in practice that fileserver.conf will

# still be used

path /file

allow *

### Unauthenticated ACL, for clients for which the current master doesn't

### have a valid certificate; we allow authenticated users, too, because

### there isn't a great harm in letting that request through.

# allow access to the master CA

path /certificate/ca

method find

allow *

path /certificate/

method find

allow *

path /certificate_request

method find, save

allow *

# this one is not stricly necessary, but it has the merit

# to show the default policy which is deny everything else

path /

auth any

allow *.deimos.fr |

Dans le cas ou vous rencontrez des problèmes d'accès, pour faire simple mais non sécurisé, ajoutez cette ligne à la fin de votre fichier de configuration le temps de vos tests :

/etc/puppet/auth.conf /etc/puppet/auth.conf

|

|

|

4.1.2 autosign.conf

Vous pouvez autosigner certains certificats pour gagner du temps. Ceci peut être un peu dangereux, mais si votre filtrage des noeuds est correctement faite derrière, pas de soucis :-)

autosign.conf autosign.conf

|

|

|

Ici je vais autosigner tous mes nodes ayant comme domaine deimos.fr

4.1.3 fileserver.conf

Donnez les autorisations des machines clientes dans le fichier /etc/puppet/fileserver.conf :

/etc/puppet/fileserver.conf /etc/puppet/fileserver.conf

|

# This file consists of arbitrarily named sections/modules

# defining where files are served from and to whom

# Define a section 'files'

# Adapt the allow/deny settings to your needs. Order

# for allow/deny does not matter, allow always takes precedence

# over deny

[files]

path /etc/puppet/files

allow *.deimos.fr# allow *.example.com

# deny *.evil.example.com

# allow 192.168.0.0/24

[plugins]

allow *.deimos.fr# allow *.example.com

# deny *.evil.example.com

# allow 192.168.0.0/24 |

4.1.4 manifests

Créons les fichiers manquants :

touch touch

|

touch /etc/puppet/manifests/{common.pp,modules.pp,site.pp} |

4.1.4.1 common.pp

Puis on va les renseigner un par un. Le common.pp est vide, mais vous pouvez y insérer des choses qui permettrons d'être pris en tant que configuration globale.

/etc/puppet/manifests/common.pp /etc/puppet/manifests/common.pp

|

|

|

4.1.4.2 modules.pp

Ensuite je vais définir ici mon ou mes modules de base. Par exemple, dans ma future configuration je vais déclarer un module "base" qui contiendra tout ce que n'importe quelle machine faisant partie de puppet héritera :

/etc/puppet/manifests/modules.pp /etc/puppet/manifests/modules.pp

|

|

|

4.1.4.3 site.pp

On demande de charger tous les modules présents dans le dossier modules :

/etc/puppet/manifests/site.pp /etc/puppet/manifests/site.pp

|

# /etc/puppet/manifests/site.pp

import "common.pp"

# The filebucket option allows for file backups to the server

filebucket { main: server => 'puppet-prod-nux.deimos.fr' }

# Backing up all files and ignore vcs files/folders

File {

backup => '.puppet-bak',

ignore => ['.svn', '.git', 'CVS' ]

}

# Default global path

Exec { path => "/usr/bin:/usr/sbin/:/bin:/sbin" }

# Import base module

import "modules.pp" |

Ici je lui dis d'utiliser le filebucket présent sur le serveur puppet et de renommer les fichiers qui vont être remplacés par puppet en <fichier>.puppet-bak.

Je lui demande également d'ignorer tout dossiers ou fichiers créer par des VCS de type SVN, gut ou CVS.

Et enfin, j'indique le path par défaut que puppet aura quant il s'exécutera sur les clients.

Il faut savoir que toute cette configuration est propre au serveur puppet, donc global. Tous ce que nous mettrons dedans pourra être hérité.

On relance le puppetmaster pour être sûr que les modifications côté serveur ont bien été prises en compte.

4.1.5 puppet.conf

J'ai volontairement passé le dossier modules car c'est le gros morceau de puppet et fera l'objet d'une attention toute particulière plus tard dans cet article.

Donc nous allons passer au fichier de configuration puppet.conf que vous avez normalement déjà configuré lors de l'installation mongrel/nginx... :

/etc/puppet/puppet.conf /etc/puppet/puppet.conf

|

[main]

logdir=/var/log/puppet

vardir=/var/lib/puppet

ssldir=/var/lib/puppet/ssl

rundir=/var/run/puppet

factpath=$vardir/lib/facter

templatedir=$confdir/templates

pluginsync = true [master]# These are needed when the puppetmaster is run by passenger# and can safely be removed if webrick is used.ssl_client_header = HTTP_X_SSL_SUBJECTssl_client_verify_header = SSL_CLIENT_VERIFYreport = true [agent]server=puppet-srv.deimos.fr |

Pour le dossier templates, je n'ai rien dedans.

4.2 Client

Chaque client doit avoir son entrée dans le serveur DNS (tout comme le serveur) !

4.2.1 puppet.conf

4.2.1.1 Debian / Red Hat

Le fichier de configuration doit contenir l'adresse du serveur :

/etc/puppet/puppet.conf /etc/puppet/puppet.conf

|

[main]

# The Puppet log directory.

# The default value is '$vardir/log'.

logdir = /var/log/puppet

# Where Puppet PID files are kept.

# The default value is '$vardir/run'.

rundir = /var/run/puppet

# Where SSL certificates are kept.

# The default value is '$confdir/ssl'.

ssldir = $vardir/ssl

# Puppet master server server = puppet-prd.deimos.fr # Add custom facts pluginsync = true pluginsource = puppet://$server/plugins factpath = /var/lib/puppet/lib/facter

[agent]

# The file in which puppetd stores a list of the classes

# associated with the retrieved configuratiion. Can be loaded in

# the separate ``puppet`` executable using the ``--loadclasses``

# option.

# The default value is '$confdir/classes.txt'.

classfile = $vardir/classes.txt

# Where puppetd caches the local configuration. An

# extension indicating the cache format is added automatically.

# The default value is '$confdir/localconfig'.

localconfig = $vardir/localconfig

# Reporting

report = true |

4.2.1.2 Solaris

Pour la partie Solaris, il a fallu pas mal adapter la configuration :

/etc/puppet/puppet.conf /etc/puppet/puppet.conf

|

[main]

logdir=/var/log/puppet

vardir=/var/opt/csw/puppet

rundir=/var/run/puppet

# ssldir=/var/lib/puppet/ssl

ssldir=/etc/puppet/ssl

# Where 3rd party plugins and modules are installed

libdir = $vardir/lib

templatedir=$vardir/templates

# Turn plug-in synchronization on.

pluginsync = true

pluginsource = puppet://$server/plugins

factpath = /var/puppet/lib/facter

[puppetd]

report=true

server=puppet-prd.deimos.fr

# certname=puppet-prd.deimos.fr

# enable the marshal config format

config_format=marshal

# different run-interval, default= 30min

# e.g. run puppetd every 4 hours = 14400

runinterval = 14400

logdest=/var/log/puppet/puppet.log |

5 Le langage

Avant de commencer la création de modules, il va falloir en connaitre un peu plus sur la syntaxe/le langage utilisé pour puppet. Il faut savoir que sa syntaxe est proche du ruby et qu'il est même possible d'écrire des modules complets en ruby. Je vais expliquer ici quelques techniques/possibilités pour vous permettre de créer des modules avancés par la suite.

Nous allons utiliser des types également, je ne rentrerais pas en détail dessus, car la doc sur le site est suffisamment clair pour cela : http://docs.puppetlabs.com/references/latest/type.html

5.1 Les fonctions

Voici comment définir une fonction avec plusieurs arguments :

define network_config( $ip, $netmask, $gateway ) {

notify {"$ip, $netmask, $gateway":}

}

network_config { "eth0":

ip => '192.168.0.1',

netmask => '255.255.255.0',

gateway => '192.168.0.254,

}5.2 Installer des packages

Nous allons voir ici comment installer un package, puis utiliser une fonction pour facilement en installer bien plus. Pour un package, c'est simple :

init.pp init.pp

|

# Install kexec-tools

package { 'kexec-tools':

ensure => 'installed'

} |

Nous demandons ici qu'un package (kexec-tool) soit installé. Si nous souhaitons que plusieurs soient installés, il va falloir créer un tableau :

init.pp init.pp

|

# Install kexec-tools

package {

[

'kexec-tools',

'package2',

'pacakge3'

]:

ensure => 'installed'

} |

C'est plutôt pratique et les tableau fonctionnent très souvent de cette manière pour a peu prêt n'importe quel type utilisé. Nous pouvons aussi créer une fonction pour cela dans laquelle nous allons lui envoyer chaque élément du tableau :

init.pp init.pp

|

# Validate that pacakges are installed

define packages_install () {

notice("Installation of ${name} package")

package {

"${name}":

ensure => 'installed'

}

}

# Set all custom packages (not embended in distribution) that need to be installed

packages_install

{ [

'puppet',

'tmux'

]: } |

Certains d'entre vous dirons que pour ce cas précis, ça ne sert à rien, puisque la méthode au dessus permet de le faire tandis que d'autres trouveront cette méthode plus élégante et facile à appréhender pour un novice qui arrive sur puppet. Le nom de la fonction utilisé est packages_install, la variable $name est toujours le premier élément envoyé à une fonction, qui correspond ici à chaque éléments de notre tableau.

5.3 Inclure / Exclure des modules

Vous venez de voir les fonctions, nous allons les poussées un peu plus loin avec une solution pour inclure et exclure le chargement de certains modules. Ici, j'ai un fichier de fonctions :

functions.pp functions.pp

|

# Load or not modules (include/exclude)

define include_modules () {

if ($exclude_modules == undef) or !($name in $exclude_modules) {

include $name

}

} |

Là j'ai un autre fichier représentant les rôles de mes serveurs (on y viendra plus tard) :

|

# Load modules

$minimal_modules =

[

'puppet',

'resolvconf',

'packages_defaults',

'configurations_defaults'

]

include_modules{ $minimal_modules: } |

Et enfin un fichier contenant le nom d'un serveur dans lequel je vais lui demander de charger certains modules, mais d'en exclure également une partie :

|

node 'srv.deimos.fr' {

$exclude_modules = [ 'resolvconf' ]

include base::minimal

} |

Ici j'utilise un tableau '$exclude_modules' (avec un seul élément, mais vous pouvez en mettre plusieurs séparés par des virgules), qui va me permettre de préciser les modules à exclude. Car par la ligne d'après il va charger tout ce dont il aura besoin grâce à la fonction include_modules.

5.4 Les templates

Lorsque vous écrivez des manifests, vous faites appelle à une directive nommée 'File' lorsque vous souhaitez envoyer un fichier sur un serveur. Mais si le contenu de ce fichier doit changer en fonction de certains paramètres (nom, ip, timezone, domaine...), alors il faut utiliser les templates ! Et c'est là que ça devient intéressant puisqu'il est possible de scripter au sein même d'un template pour en générer le contenu. Les templates utilisent un langage très proche de celui du ruby.

Dans un template, la syntaxe suivante est utilisée :

- Pour les facts, c’est simple, il faut préfixer la variable par un “@”. Par exemple <%= fqdn %> devient <%= @fqdn %>.

- Pour vos variables, si elle est déclarée dans le manifest qui appelle le template, utilisez également le “@”.

- Ma variable myvar définie dans le manifeste qui appelle ce template a pour valeur <%= myvar %>.

Dans le cas ou vous souhaitez accéder à une variable définie en dehors du manifest actuel, en dehors du scope local, utilisez la fonction scope.lookupvar :

<%= scope.lookupvar('common::config::myvar') %>Vous pouvez valider votre template via :

erb erb

|

erb -P -x -T '-' mytemplate.erb | ruby -c |

Voici un exemple avec OpenSSH pour que vous compreniez. J'ai donc pris la configuration qui va varier selon certains paramètres :

/etc/puppet/modules/ssh/templates/sshd_config /etc/puppet/modules/ssh/templates/sshd_config

|

# Package generated configuration file

# See the sshd(8) manpage for details

# What ports, IPs and protocols we listen for

<% ssh_default_port.each do |val| -%>

Port <%= val -%>

<% end -%>

# Use these options to restrict which interfaces/protocols sshd will bind to

#ListenAddress ::

#ListenAddress 0.0.0.0

Protocol 2

# HostKeys for protocol version 2

HostKey /etc/ssh/ssh_host_rsa_key

HostKey /etc/ssh/ssh_host_dsa_key

#Privilege Separation is turned on for security

UsePrivilegeSeparation yes

# Lifetime and size of ephemeral version 1 server key

KeyRegenerationInterval 3600

ServerKeyBits 768

# Logging

SyslogFacility AUTH

LogLevel INFO

# Authentication:

LoginGraceTime 120

PermitRootLogin yes

StrictModes yes

RSAAuthentication yes

PubkeyAuthentication yes

#AuthorizedKeysFile %h/.ssh/authorized_keys

# Don't read the user's ~/.rhosts and ~/.shosts files

IgnoreRhosts yes

# For this to work you will also need host keys in /etc/ssh_known_hosts

RhostsRSAAuthentication no

# similar for protocol version 2

HostbasedAuthentication no

# Uncomment if you don't trust ~/.ssh/known_hosts for RhostsRSAAuthentication

#IgnoreUserKnownHosts yes

# To enable empty passwords, change to yes (NOT RECOMMENDED)

PermitEmptyPasswords no

# Change to yes to enable challenge-response passwords (beware issues with

# some PAM modules and threads)

ChallengeResponseAuthentication no

# Change to no to disable tunnelled clear text passwords

#PasswordAuthentication yes

# Kerberos options

#KerberosAuthentication no

#KerberosGetAFSToken no

#KerberosOrLocalPasswd yes

#KerberosTicketCleanup yes

# GSSAPI options

#GSSAPIAuthentication no

#GSSAPICleanupCredentials yes

X11Forwarding yes

X11DisplayOffset 10

PrintMotd no

PrintLastLog yes

TCPKeepAlive yes

#UseLogin no

#MaxStartups 10:30:60

#Banner /etc/issue.net

# Allow client to pass locale environment variables

AcceptEnv LANG LC_*

Subsystem sftp /usr/lib/openssh/sftp-server

UsePAM yes

# AllowUsers <%= ssh_allowed_users %>

|

Ici nous utilisons donc 2 types d'utilisation de templates. Une multi lignes a répétition, et l'autre avec un simple remplacement de variables :

- ssh_default_port.each do : permet de mettre une ligne de "Port num_port" a chaque port spécifié

- ssh_allowed_users : permet de donner une liste d'utilisateur

Ces variables sont généralement a déclarer soit dans la partie 'node' ou bien dans la configuration globale. Nous venons de voir comment mettre une variable ou une boucle dans un template, mais sachez qu'il est également possible de mettre des if ! Bref, un langage complet existe et vous permet de moduler a souhait un fichier.

Ces méthodes s'avèrent simple et très efficaces. Petite subtilité :

- -%> : Lorsqu'une ligne se termine comme ceci, c'est qu'il ne va pas y avoir de saut de ligne grâce au - situé à la fin.

- %> : Il y aura un saut de ligne ici.

5.4.1 Les inline-templates

Ceci est une petite subtilité qui peut paraitre inutile, mais est en fait très utile pour exécuter de petites méthodes au sein d'un manifest ! Prenez par exemple la fonction 'split' qui aujourd'hui existe dans puppet, il semblerait normal que la fonction 'join' existe non ? Et bien non...enfin pas dans la version actuelle au moment ou j'écris ces lignes (la 2.7.18). Je peux donc utiliser de la même façons que les templates du code dans mes manifests, voyez plutôt :

$ldap_servers = [ '192.168.0.1', '192.168.0.2', '127.0.0.1' ]

$comma_ldap_servers = inline_template("<%= (ldap_servers).join(',') %>")- $ldap_servers : ceci est un simple tableau avec ma liste de serveurs LDAP

- $comma_ldap_servers : nous utilisons la fonction inline_template, qui va appeler la fonction join, lui passer le tableau ldap_servers et joindre le contenu avec des virgules.

J'aurais au finale :

$comma_ldap_servers = '192.168.0.1,192.168.0.2,127.0.0.1'

5.5 Les Facters

Les "facts", sont des scripts (voir /usr/lib/ruby/1.8/facter pour les facts standards) permettant de construire des variables dynamiques, qui changent en fonction de l'environnement dans lequel ils sont exécutés.

Par exemple, on pourra définir un "fact", qui détermine si l'on est sur une machine de type "cluster" en fonction de la présence ou l'absence d'un fichier :

is_cluster.rb is_cluster.rb

|

# is_cluster.rb

Facter.add("is_cluster") do

setcode do

FileTest.exists?("/etc/cluster/nodeid")

end

end |

On peut aussi utiliser de fonctions qui permettent de mettre directement dans des templates, des fonctions de type facter (downcase ou upcase pour changer la casse) :

modules/collectd/templates/collectd.conf modules/collectd/templates/collectd.conf

|

#

# Config file for collectd(1).

# Please read collectd.conf(5) for a list of options.

# http://collectd.org/

#

Hostname <%= hostname.downcase %>FQDNLookup true |

Attention, si l'on veut tester le fact sur la machine destination, il ne faudra pas oublier de spécifier le chemin ou se trouvent les facts sur la machine :

export export

|

export FACTERLIB=/var/lib/puppet/lib/facter

|

ou pour Solaris :

export export

|

export FACTERLIB=/var/opt/csw/puppet/lib/facter

|

Pour voir la liste des facts ensuite présent sur le système, il faut simplement taper la commander facter :

facter facter

|

> facter

facterversion => 1.5.7

hardwareisa => i386

hardwaremodel => i86pc

hostname => PA-OFC-SRV-UAT-2

hostnameldap => PA-OFC-SRV-UAT

id => root

interfaces => lo0,e1000g0,e1000g0_1,e1000g0_2,e1000g1,e1000g2,e1000g3,clprivnet0

... |

Voir http://docs.puppetlabs.com/guides/custom_facts.html pour plus de détails.

5.6 Informations dynamiques

Il est possible d'utiliser des scripts côté serveur et d'en récupérer le contenu dans une variable. Voici un exemple :

/usr/bin/latest_puppet_version.rb /usr/bin/latest_puppet_version.rb

|

#!/usr/bin/ruby

require 'open-uri'

page = open("http://www.puppetlabs.com/misc/download-options/").read

print page.match(/stable version is ([\d\.]*)/)[1] |

Et dans le manifest :

$latestversion = generate("/usr/bin/latest_puppet_version.rb")

notify { "The latest stable Puppet version is ${latestversion}. You're using ${puppetversion}.": }Magique non ? :-). Sachez qu'il est même possible de passer des arguments avec une virgule entre chaque !!!

5.7 Les Parsers

Les parsers sont la création de fonctions particulières utilisables dans les manifests (côté serveur). Par exemple, j'ai créer un parser qui va me permettre de faire du reverse lookup dns :

/etc/puppet/modules/openldap/lib/puppet/parser/functions/dns2ip.rb /etc/puppet/modules/openldap/lib/puppet/parser/functions/dns2ip.rb

|

# Dns2IP for Puppet

# Made by Pierre Mavro

# Does a DNS lookup and returns an array of strings of the results

# Usage : need to send one string dns servers separated by comma. The return will be the same

require 'resolv'

module Puppet::Parser::Functions

newfunction(:dns2ip, :type => :rvalue) do |arguments|

result = [ ]

# Split comma sperated list in array

dns_array = arguments[0].split(',')

# Push each DNS/IP address in result array

dns_array.each do |dns_name|

result.push(Resolv.new.getaddresses(dns_name))

end

# Join array with comma

dns_list = result.join(',')

# Delete last comma if exist

good_dns_list = dns_list.gsub(/,$/, '')

return good_dns_list

end

end |

Nous allons pouvoir créer cette variable puis l'insérer dans nos manifests :

$comma_ldap_servers = 'ldap1.deimos.fr,ldap2.deimos.fr,127.0.0.1'

$ip_ldap_servers = dns2ip("${comma_ldap_servers}")J'envoie ici une liste de serveur LDAP et il me sera retourné leurs adresses IP. Vous comprenez maintenant que c'est un appel, un peu comme les inline_templates, mais qui est bien plus puissant.

Notes Notes

|

|

J'ai pu constater un comportement de cache assez désagréable avec ce type de fonctions ! En effet, lorsque vous développez un parser et que vous le testez, il est fort probable que vous utilisiez des fonctions 'Notify' dans vos manifests pour debugger. Cependant les modifications que vous ferez sur votre parser ne s'appliqueront pas forcément tant que vous n'aurez pas vidé les caches. Après quelques recherches et demandes IRC, il s'avère que la seule méthode fonctionnelle soit de redémarrer le Puppet Master et le serveur web (Nginx dans notre cas). Ca fonctionne très bien, mais c'est un peu pénible lors de la phase de debug.

|

5.8 Du Ruby dans vos manifests

Il est tout à fait possible d'écrire du Ruby dans vos manifests. Voyez plutôt :

notice( "I am running on node %s" % scope.lookupvar("fqdn") )Ca ressemble fortement à un sprintf.

5.9 Ajouter une variable Ruby dans les manifests

Si nous souhaitons par exemple récupérer l'heure actuelle dans un manifest :

require 'time'

scope.setvar("now", Time.now)

notice( "Here is the current time : %s" % scope.lookupvar("now") )5.10 Les classes

On peut utiliser des classes avec des arguments comme ceci :

class mysql( $package, $socket, $port = "3306" ) {

…

}

class { "mysql":

package => "percona-sql-server-5.0",

socket => "/var/run/mysqld/mysqld.sock",

port => "3306",

}5.11 Utilisation des tables de hash

Tout comme les tableaux, il est également possible d'utilise les tables de hasch, regardez cet exemple :

$interface = {

name => 'eth0',

address => '192.168.0.1'

}

notice("Interface ${interface[name]} has address ${interface[address]}")5.12 Les regex

Il est possible d'utiliser les regex et d'en récupérer les patterns :

$input = "What a great tool"

if $input =~ /What a (\w+) tool/ {

notice("You said the tool is : '$1'. The complete line is : $0")

}5.13 Substitution

Il est possible de substituer :

$ipaddress = '192.168.0.15'

$class_c = regsubst($ipaddress, "(.*)\..*", "\1.0")

notify { $ipaddress: }

notify { $class_c: }Ce qui me donnera 192.168.0.15 et 192.168.0.0.

5.14 Notify et Require

Ces 2 fonctions sont fortes utiles une fois insérées dans un manifest. Cela permet par exemple à un service de dire qu'il require (require) un Package pour fonctionner et à un fichier de configuration de notifier (notify) un service s'il change pour que celui ci redémarre le démon. On peut également écrire quelque chose comme ceci :

Package["ntp"] -> File["/etc/ntp.conf"] ~> Service["ntp"]

- -> : signifie 'require'

- ~> : signifie 'notify'

Il est également possible de faire des require sur des classes :-)

5.15 L'opérateur +>

Voici un superbe opérateur qui va nous permettre de gagner un peu de temps. L'exemple ci dessous :

file { "/etc/ssl/certs/cookbook.pem":

source => "puppet:///modules/apache/deimos.pem",

}

Service["apache2"] {

require +> File["/etc/ssl/certs/deimos.pem"],

}Correspond à :

service { "apache2":

enable => true, ensure => running, require => File["/etc/ssl/certs/deimos.pem"],

}5.16 Vérifier le numéro de version d'un soft

Si vous avez besoin de vérifier le numéro e version d'un soft pour prendre ensuite une décision, voici un bon exemple :

$app_version = "2.7.16"

$min_version = "2.7.18"

if versioncmp( $app_version, $min_version ) >= 0 {

notify { "Puppet version OK": }

} else {

notify { "Puppet upgrade needed": }

}5.17 Les ressources virtuelles

Utile pour les écritures de test, vous pouvez par exemple créer une ressource en la précédent d'un '@'. Elle sera lue mais non exécutée jusqu'à ce qu'implicitement vous lui indiquiez (realize). Exemple :

@package {

'postfix':

ensure => installed

}

realize( Package[''postfix] )Un des gros avantages de cette méthode est de pouvoir déclarer à plusieurs endroits dans votre puppet master le realize sans pour autant que vous ayez de conflits !

5.18 Suppression d'un fichier évoluée

Vous pouvez demander la suppression d'un fichier au bout d'un temps donné ou bien à partir d'une certaine taille :

tidy { "/var/lib/puppet/reports":

age => "1w",

size => "512k",

recurse => true,

}Ceci entrainera la suppression d'un dossier au bout d'une semaine avec son contenu.

6 Les modules

Il est recommandé de créer des modules pour chaque service afin de rendre la configuration plus souple. Ca fait partie de certaines best practices.

Je vais aborder ici différentes techniques en essayant de garder un ordre croissant de difficulté.

6.1 Initialisation d'un module

Nous allons donc créer sur le serveur, l'arborescence adéquate. Pour cet exemple, nous allons partir avec "sudo", mais vous pouvez choisir autre chose si vous souhaitez :

|

mkdir -p /etc/puppet/modules/sudo/manifests

touch /etc/puppet/modules/sudo/manifests/init.pp |

N'oubliez pas que ceci est nécessaire pour chaque module. Le fichier init.pp est le premier fichier qui se chargera lors de l'appel au module.

6.2 Le module initiale (base)

Il nous faut créer un module initiale qui va gérer la liste des serveurs, les fonctions dont nous allons avoir besoin, les roles, des variables globales... bref, ça peut paraitre un peu abstrait au premier abord mais sachez juste qu'il nous faut un module pour gérer ensuite tous les autres. Nous allons commencer par celui là qui est un des plus important pour la suite.

Comme vous le savez maintenant, il nous faut un fichier init.pp pour que le premier module soit chargé. Nous allons donc créer notre arborescence que nous allons appeler "base" :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/base/{manifests,puppet/parser/functions} |

6.2.1 init.pp

Puis nous allons créer et renseigner le fichier init.pp :

/etc/puppet/modules/base/manifests/init.pp /etc/puppet/modules/base/manifests/init.pp

|

################################################################################

# BASE MODULES #

################################################################################

# Load defaults vars

import "vars.pp"

# Load functions

import "functions.pp"

# Load sysctl module

include "sysctl"

# Load network module

include "network"

# Load roles

import "roles.pp"

# Set servers properties

import "servers.pp" |

Les lignes correspondantes à import sont équivalentes à un "include" (dans des services comme ssh ou nrpe) de mes autres fichier .pp que nous allons créer par la suite. Tandis que les include vont charger d'autres modules que je vais créer par la suite.

6.2.2 vars.pp

Nous allons ensuite créer le fichier vars.pp qui contiendra toutes mes variables globales pour mes futurs modules ou manifests (*.pp) :

/etc/puppet/modules/base/manifests/vars.pp /etc/puppet/modules/base/manifests/vars.pp

|

################################################################################

# VARS #

################################################################################

# Default admins emails

$root_email = 'deimos@deimos.fr'

# NTP Timezone. Usage :

# Look at /usr/share/zoneinfo/ and add the continent folder followed by the town

$set_timezone = 'Europe/Paris'

# Define empty exclude modules

$exclude_modules = [ ]

# Default LDAP servers

$ldap_servers = [ ]

# Default DNS servers

$dns_servers = [ '192.168.0.69', '192.168.0.27' ] |

6.2.3 functions.pp

Maintenant, nous allons créer des fonctions qui vont nous permettre de rajouter quelques fonctionnalités aujourd'hui non présentes dans puppet ou en simplifier certaines :

/etc/puppet/modules/base/manifests/functions.pp /etc/puppet/modules/base/manifests/functions.pp

|

/* Puppet Functions Made by Pierre Mavro */ ################################################################################ # GLOBAL FUNCTIONS # ################################################################################ # Load or not modules (include/exclude) define include_modules () { if ($exclude_modules == undef) or !($name in $exclude_modules) { include $name } } # Validate that pacakges are installed define packages_install () { notice("Installation of ${name} package") package { "${name}": ensure => present } } # Check that those services are enabled on boot or not define services_start_on_boot ($enable_status) { service { "${name}": enable => "${enable_status}" } } # Add, remove, comment or uncomment lines define line ($file, $line, $ensure = 'present') { case $ensure { default : { err("unknown ensure value ${ensure}") } present : { exec { "echo '${line}' >> '${file}'" : unless => "grep -qFx '${line}' '${file}'", logoutput => true } } absent : { exec { "grep -vFx '${line}' '${file}' | tee '${file}' > /dev/null 2>&1" : onlyif => "grep -qFx '${line}' '${file}'", logoutput => true } } uncomment : { exec { "sed -i -e'/${line}/s/#\+//' '${file}'" : onlyif => "test `grep '${line}' '${file}' | grep '^#' | wc -l` -ne 0", logoutput => true } } comment : { exec { "/bin/sed -i -e'/${line}/s/\(.\+\)$/#\1/' '${file}'" : onlyif => "test `grep '${line}' '${file}' | grep -v '^#' | wc -l` -ne 0", logoutput => true } } # Use this resource instead if your platform's grep doesn't support -vFx; # note that this command has been known to have problems with lines containing quotes. # exec { "/usr/bin/perl -ni -e 'print unless /^\\Q${line}\\E\$/' '${file}'": # onlyif => "grep -qFx '${line}' '${file}'" # } } } # Validate that softwares are installed define comment_lines ($filename) { line { "${name}" : file => "${filename}", line => "${name}", ensure => comment } } # Sysctl managment class sysctl { define conf ($value) { # $name is provided by define invocation # guid of this entry $key = $name $context = "/files/etc/sysctl.conf" augeas { "sysctl_conf/$key" : context => "$context", onlyif => "get $key != '$value'", changes => "set $key '$value'", notify => Exec["sysctl"], } } file { "sysctl_conf" : name => $::operatingsystem ? { default => "/etc/sysctl.conf", }, } exec { "sysctl -p" : alias => "sysctl", refreshonly => true, subscribe => File["sysctl_conf"], } } # Function to add ssh public keys define ssh_add_key ($user, $key) { # Create users home directory if absent exec { "mkhomedir_${name}" : path => "/bin:/usr/bin", command => "cp -Rfp /etc/skel ~$user; chown -Rf $user:group ~$user", onlyif => "test `ls ~$user 2>&1 >/dev/null | wc -l` -ne 0" } ssh_authorized_key { "${name}" : ensure => present, key => "$key", type => 'ssh-rsa', user => "$user", require => Exec["mkhomedir_${name}"] } } # Limits.conf managment define limits_conf ($domain = "root", $type = "soft",$item = "nofile", $value = "10000") { # guid of this entry $key = "$domain/$type/$item" # augtool> match /files/etc/security/limits.conf/domain[.="root"][./type="hard" and ./item="nofile" and ./value="10000"] $context = "/files/etc/security/limits.conf" $path_list = "domain[.=\"$domain\"][./type=\"$type\" and ./item=\"$item\"]" $path_exact = "domain[.=\"$domain\"][./type=\"$type\" and ./item=\"$item\" and ./value=\"$value\"]" augeas { "limits_conf/$key" : context => "$context", onlyif => "match $path_exact size==0", changes => [ # remove all matching to the $domain, $type, $item, for any $value "rm $path_list", # insert new node at the end of tree "set domain[last()+1] $domain", # assign values to the new node "set domain[last()]/type $type", "set domain[last()]/item $item", "set domain[last()]/value $value",], } }

|

Nous avons donc :

- Ligne 10 : La possibilité de charger ou non des modules via un tableau envoyé en argument de fonction (comme décrit plus haut dans cette documentation)

- Ligne 17 : La possibilité de vérifier que des packages sont installés sur la machine

- Ligne 26 : La possibilité de vérifier que des services sont correctement chargés au boot de la machine

- Ligne 34 : La possibilité de s'assurer qu'une ligne d'un fichier est présente, absente, commentée ou non non commentée

- Ligne 78 : La possibilité de commenter plusieurs lignes via un tableau envoyé en argument de fonction

- Ligne 88 : La possibilité de gérer le fichier sysctl.conf

- Ligne 117 : La possibilité de déployer facilement des clefs publiques SSH

- Ligne 128 : La possibilité de gérer simplement le fichier limits.conf

Toutes ses fonctions ne sont bien entendues pas obligatoires mais aident grandement à l'utilisation de puppet.

6.2.4 roles.pp

Ensuite nous avons un fichier contenant le rôles des serveurs. Voyez ça plutôt comme des groupes auxquels nous allons faire souscrire les serveurs :

/etc/puppet/modules/base/manifests/roles.pp /etc/puppet/modules/base/manifests/roles.pp

|

################################################################################

# ROLES #

################################################################################

# Level 1 : Minimal

class base::minimal

{

# Load modules

$minimal_modules =

[

'stdlib',

'puppet',

'resolvconf',

'packages_defaults',

'configurations_defaults',

'openssh',

'selinux',

'grub',

'kdump',

'tools',

'timezone',

'ntp',

'mysecureshell',

'openldap',

'acl',

'sudo',

'snmpd',

'postfix',

'nrpe'

]

include_modules{ $minimal_modules: }

}

# Level 2 : Cluster

class base::cluster inherits minimal

{

# Load modules

$cluster_modules =

[

'packages_cluster',

'configurations_cluster'

]

include_modules{ $cluster_modules: }

}

# Level 2 : Low Latency

class base::low_latency inherits minimal

{

# Load modules

$lowlatency_modules =

[

'low_latency'

]

include_modules{ $lowlatency_modules: }

}

# Level 3 : Low Latency + Cluster

class base::low_latency_cluster inherits minimal

{

include base::cluster

include base::low_latency

} |

J'ai donc définit ici des classes qui héritent plus ou moins entre elles. C'est en fait définit par niveaux. Le niveau 3 dépends du 2 et 1, le 2 du 1 et le 1 n'a pas de dépendances. Cela me permet d'avoir une certaine souplesse. Je sais par exemple ici que si je charge ma classe cluster, ma classe minimal sera également chargée. Vous noterez l'annotation 'base::minimal'. Il est recommandé de charger ses classes en appelant le module, suivit de '::'. Cela facilite grandement la lecture des manifests.

6.2.5 servers.pp

Et pour finir, j'ai un fichier ou je fais ma déclaration de serveurs :

/etc/puppet/modules/base/manifests/servers.pp /etc/puppet/modules/base/manifests/servers.pp

|

/*##############################################################################

# SERVERS #

################################################################################

== Automated Dependancies Roles ==

* cluster -> minimal

* low_latency -> minimal

* low_latency_cluster -> low_latency + cluster + minimal

== Template for servers ==

node /regex/

{

#$exclude_modules = [ ]

#$ldap_servers = 'x.x.x.x'

#$set_timezone = 'Europe/Paris'

#$dns_servers = [ ]

#include base::minimal

#include base::cluster

#include base::low_latency

#include base::low_latency_cluster

}

##############################################################################*/

# One server

node 'srv1.deimos.fr' {

$ldap_servers = [ '127.0.0.1' ]

include base::minimal

}

# Multiple servers

node 'srv2.deimos.fr' 'srv3.deimos.fr' {

$ldap_servers = [ '127.0.0.1' ]

include base::minimal

}

# Multiple regex based servers

node /srv-prd-\d+/ {

include base::minimal

include base::low_latency

$set_timezone = 'Europe/London'

} |

Ici j'ai mis un serveur en exemple ou une regex pour plusieurs serveurs. Pour info, la configuration peut être intégrée dans LDAP.

6.2.6 Parser

Nous allons créer l'arborescence nécessaire :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/base/puppet/parser/functions |

Puis ajoutez un parser empty qui nous permettra de détecter si un tableau/une variable est vide ou non :

/etc/puppet/modules/base/puppet/parser/functions/empty.rb /etc/puppet/modules/base/puppet/parser/functions/empty.rb

|

#

# empty.rb

#

# Copyright 2011 Puppet Labs Inc.

# Copyright 2011 Krzysztof Wilczynski

#

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

#

module Puppet::Parser::Functions

newfunction(:empty, :type => :rvalue, :doc => <<-EOS

Returns true if given array type or hash type has no elements or when a string

value is empty and false otherwise.

Prototype:

empty(x)

Where x is either an array, a hash or a string value.

For example:

Given the following statements:

$a = ''

$b = 'abc'

$c = []

$d = ['d', 'e', 'f']

$e = {}

$f = { 'x' => 1, 'y' => 2, 'z' => 3 }

notice empty($a)

notice empty($b)

notice empty($c)

notice empty($d)

notice empty($e)

notice empty($f)

The result will be as follows:

notice: Scope(Class[main]): true

notice: Scope(Class[main]): false

notice: Scope(Class[main]): true

notice: Scope(Class[main]): false

notice: Scope(Class[main]): true

notice: Scope(Class[main]): false

EOS

) do |*arguments|

#

# This is to ensure that whenever we call this function from within

# the Puppet manifest or alternatively form a template it will always

# do the right thing ...

#

arguments = arguments.shift if arguments.first.is_a?(Array)

raise Puppet::ParseError, "empty(): Wrong number of arguments " +

"given (#{arguments.size} for 1)" if arguments.size < 1

value = arguments.shift

unless [Array, Hash, String].include?(value.class)

raise Puppet::ParseError, 'empty(): Requires either array, hash ' +

'or string type to work with'

end

value.empty?

end

end

# vim: set ts=2 sw=2 et :

# encoding: utf-8 |

7 Exemples de modules

7.1 stdlib

Ce module stdlib n'est pas indispensable, mais il est utile si vous manquez de fonctionnalités dans Puppet. En effet, il apporte un lot assez important de fonctions :

abs ensure_resource include loadyaml reverse to_bytes

bool2num err info lstrip rstrip type

capitalize extlookup inline_template md5 search unique

chomp fail is_array member sha1 upcase

chop file is_domain_name merge shellquote validate_absolute_pa

create_resources flatten is_float notice size validate_array

crit fqdn_rand is_hash num2bool sort validate_bool

debug fqdn_rotate is_integer parsejson squeeze validate_hash

defined generate is_ip_address parseyaml str2bool validate_re

defined_with_params get_module_path is_mac_address prefix str2saltedsha512 validate_slength

delete getvar is_numeric range strftime validate_string

delete_at grep is_string realize strip values

downcase has_key join regsubst swapcase values_at

emerg hash keys require time zip

empty

Créez d'abord l'arborescence :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/stdlib |

Téléchargez la dernière version et décompressez là tout simplement :

|

cd /etc/puppet/modules/stdlib

wget http://forge.puppetlabs.com/puppetlabs/stdlib/3.2.0.tar.gz

tar -xzf 3.2.0.tar.gz

mv puppetlabs-stdlib-3.2.0/stdlib stdlib

rm -f 3.2.0.tar.gz |

7.2 Puppet

Celui ci est assez drôle car en fait il s'agit simplement de la configuration du client Puppet. Cependant, il peut s'avérer très utile pour sa gérer ses propres mises à jour. Nous allons donc créer les arborescences :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/puppet/{manifests,files} |

7.2.1 init.pp

Nous créons ici le module init.pp qui va nous permettre selon l'OS de choisir le fichier à charger.

/etc/puppet/modules/puppet/manifests/init.pp /etc/puppet/modules/puppet/manifests/init.pp

|

/*

Puppet Module for Puppet

Made by Pierre Mavro

*/

class puppet {

# Check OS and request the appropriate function

case $::operatingsystem {

'RedHat' : {

include ::puppet::redhat

}

#'sunos': { include packages_defaults::solaris }

default : {

notice("Module ${module_name} is not supported on ${::operatingsystem}")

}

}

} |

7.2.2 redhat.pp

/etc/puppet/modules/puppet/manifests/redhat.pp /etc/puppet/modules/puppet/manifests/redhat.pp

|

/*

Puppet Module for Puppet

Made by Pierre Mavro

*/

class puppet::redhat {

# Change default configuration

file {

'/etc/puppet/puppet.conf' :

ensure => present,

source => "puppet:///modules/puppet/${::osfamily}.puppet.conf", mode => 644,

owner => root,

group => root

}

# Disable service on boot and be sure it is not started

service {

'puppet-srv' :

name => 'puppet',

# Let this line commented if you're using Puppet Dashboard

#ensure => stopped,

enable => false

}

} |

A la ligne 9, nous utilisons une variable disponible dans les facts (côté client) pour qu'en fonction de la réponse, nous chargeons un fichier associé à à l'OS. Nous allons donc avoir un fichier de configuration accessible via Puppet sous la forme 'RedHat.puppet.conf'.

Ensuite, le service, nous nous assurons qu'il soit bien stoppé au démarrage et qu'il est dans un état éteint pour le moment. En fait je ne souhaites pas que toutes les 30 minutes (valeur par défaut), il se déclenche et se synchronise, je trouve ça trop dangereux et préfère décider via d'autres mécanismes (SSH, Mcollective...) quant je souhaites qu'une synchronisation soit faite.

7.2.3 files

Dans files, nous allons avoir le fichier de configuration basique qui doit s'appliquer à toutes les machines de type RedHat :

/etc/puppet/modules/puppet/files/RedHat.puppet.conf /etc/puppet/modules/puppet/files/RedHat.puppet.conf

|

[main]

# The Puppet log directory.

# The default value is '$vardir/log'.

logdir = /var/log/puppet

# Where Puppet PID files are kept.

# The default value is '$vardir/run'.

rundir = /var/run/puppet

# Where SSL certificates are kept.

# The default value is '$confdir/ssl'.

ssldir = $vardir/ssl

# Puppet master server

server = puppet-prd.deimos.fr

# Add custom facts

pluginsync = true

pluginsource = puppet://$server/plugins

factpath = /var/lib/puppet/lib/facter

[agent]

# The file in which puppetd stores a list of the classes

# associated with the retrieved configuratiion. Can be loaded in

# the separate ``puppet`` executable using the ``--loadclasses``

# option.

# The default value is '$confdir/classes.txt'.

classfile = $vardir/classes.txt

# Where puppetd caches the local configuration. An

# extension indicating the cache format is added automatically.

# The default value is '$confdir/localconfig'.

localconfig = $vardir/localconfig

# Reporting

report = true

# Inspect reports for a compliance workflow

archive_files = true |

7.3 resolvconf

J'ai fais ce module pour gérer le fichier de configuration resolv.conf. L'utilisation est assez simple, il va récupérer les informations des serveurs DNS resneigné dans le tableau disponible dans vars.pp du module base. Renseignez donc les serveurs DNS par défaut :

/etc/puppet/modules/base/manifests/vars.pp /etc/puppet/modules/base/manifests/vars.pp

|

# Default DNS servers

$dns_servers = [ '192.168.0.69', '192.168.0.27' ] |

Vous pouvez surclasser ces valeurs directement au niveau d'un ou plusieurs noeuds si vous devez avoir des configuration spécifiques pour certains neouds (dans le fichier servers.pp du module base) :

/etc/puppet/modules/base/manifests/servers.pp /etc/puppet/modules/base/manifests/servers.pp

|

# One server

node 'srv.deimos.fr' {

$dns_servers = [ '127.0.0.1' ]

include base::minimal

} |

Créons l'arborescence :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/resolvconf/{manifests,templates} |

7.3.1 init.pp

/etc/puppet/modules/resolvconf/manifests/init.pp /etc/puppet/modules/resolvconf/manifests/init.pp

|

/*

Resolv.conf Module for Puppet

Made by Pierre Mavro

*/

class resolvconf {

# Check OS and request the appropriate function

case $::operatingsystem {

'RedHat' : {

include resolvconf::redhat

}

#'sunos': { include packages_defaults::solaris }

default : {

notice("Module ${module_name} is not supported on ${::operatingsystem}")

}

}

} |

7.3.2 redhat.pp

Voici la configuration pour Red Hat, j'utilise ici un fichier template, qui se renseignera avec les informations présente dans le tableau $dns_servers :

/etc/puppet/modules/resolvconf/manifests/redhat.pp /etc/puppet/modules/resolvconf/manifests/redhat.pp

|

/*

Resolvconf Module for Puppet

Made by Pierre Mavro

*/

class resolvconf::redhat {

# resolv.conf file

file {

"/etc/resolv.conf" :

content => template("resolvconf/resolv.conf"),

mode => 744,

owner => root,

group => root

}

} |

7.3.3 templates

Et enfin mon fichier template resolv.conf :

/etc/puppet/modules/resolvconf/templates/resolv.conf /etc/puppet/modules/resolvconf/templates/resolv.conf

|

# Generated by Puppet

domain deimos.fr

search deimos.fr deimos.lan

<% dns_servers.each do |dnsval| -%>

nameserver <%= dnsval %>

<% end -%> |

Ici nous avons une boucle ruby qui va parcourir le tableau $dns_servers et qui va construire le fichier resolv.conf en insérant ligne par ligne 'nameserver' avec le serveur associé.

7.4 packages_defaults

J'utilise se module pour qu'il installe ou désinstalle des packages dont j'ai absolument besoin sur toutes mes machines. Créons l’arborescence :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/packages_defaults/manifests |

7.4.1 init.pp

/etc/puppet/modules/packages_defaults/manifests/init.pp /etc/puppet/modules/packages_defaults/manifests/init.pp

|

class packages_defaults {

# Check OS and request the appropriate function

case $::operatingsystem {

'RedHat' : {

include ::packages_defaults::redhat

}

#'sunos': { include packages_defaults::solaris }

default : {

notice("Module ${module_name} is not supported on ${::operatingsystem}")

}

}

} |

7.4.2 redhat.pp

J'aurais pu tout regroupé dans un seul bloc, mais par soucis de lisiblité sur les packages qui figurent dans la distribution et ceux que j'ai rajouté dans un repository custom, j'ai préféré faire une séparation :

/etc/puppet/modules/packages_defaults/manifests/redhat.pp /etc/puppet/modules/packages_defaults/manifests/redhat.pp

|

# Red Hat Defaults packages

class packages_defaults::redhat

{

# Set all default packages (embended in distribution) that need to be installed

packages_install

{ [

'nc',

'tree',

'telnet',

'dialog',

'freeipmi',

'glibc-2.12-1.80.el6.i686'

]: }

# Set all custom packages (not embended in distribution) that need to be installed

packages_install

{ [

'puppet',

'tmux'

]: }

} |

7.5 configurations_defaults

Ce module, tout comme le précédent est utilisé pour la configuration de l'OS livré en standard. Je souhaites en fait ici faire des ajustements sur des parties du système pure, sans vraiment rentrer sur un logiciel en particulier. Créons l'arborescence :

mkdir mkdir

|

mkdir -p /etc/puppet/modules/configuration_defaults/{manifests,templates,lib/facter} |

7.5.1 init.pp

/etc/puppet/modules/configuration_defaults/manifests/init.pp /etc/puppet/modules/configuration_defaults/manifests/init.pp

|

class configurations_defaults {

import '*.pp'

# Configure common security parameters

include configurations_defaults::common

# Check OS and request the appropriate function

case $::operatingsystem {

'RedHat' : {

include configurations_defaults::redhat

}

default : {

notice("Module ${module_name} is not supported on ${::operatingsystem}")

}

}

} |

Ici je viens charger tous les fichiers .pp au démarrage, puis appelle importe les configuration communes (common), ensuite j'applique les configurations spécifiques à chaque OS.

7.5.2 common.pp

Ici je souhaites avoir la même base de fichier motd pour toutes mes machines. Vous verrez par la suite pourquoi il figure en tant que template :

/etc/puppet/modules/configuration_defaults/manifests/common.pp /etc/puppet/modules/configuration_defaults/manifests/common.pp

|

class configurations_defaults::common

{

# Motd banner for all servers

file {

'/etc/motd':

ensure => present,

content => template("configurations_defaults/motd"),

mode => 644,

owner => root,

group => root

}

} |

7.5.3 redhat.pp

Je vais ici charger des options de sécurité, configurer automatiquement le bonding sur mes machines et une option de sysctl :

/etc/puppet/modules/configuration_defaults/manifests/redhat.pp /etc/puppet/modules/configuration_defaults/manifests/redhat.pp

|

class configurations_defaults::redhat

{

# Security configurations

include 'configurations_defaults::redhat::security'

# Configure bonding

include 'configurations_defaults::redhat::network'

# Set sysctl options

sysctl::conf

{

'vm.swappiness': value => '0';

}

} |

7.5.4 security.pp

Vous allez voir que ce fichier fait pas mal de choses :

/etc/puppet/modules/configuration_defaults/manifests/security.pp /etc/puppet/modules/configuration_defaults/manifests/security.pp

|

class configurations_defaults::redhat::security inherits configurations_defaults::redhat

{

# Manage Root passwords $sha512_passwd='$6$lhkAz...'

$md5_passwd='$1$Fcwy...'

if ($::passwd_algorithm == sha512)

{

# sha512 root password

$root_password="$sha512_passwd"

}

else

{

# MD5 root password

$root_password="$md5_passwd"

}

user {

'root':

ensure => present,

password => "$root_password"

}

# Enable auditd service service {

"auditd" :

enable => true,

ensure => 'running',

}

# Comment unwanted sysctl lines $sysctl_file = '/etc/sysctl.conf'

$sysctl_comment_lines =

[

"net.bridge.bridge-nf-call-ip6tables",

"net.bridge.bridge-nf-call-iptables",

"net.bridge.bridge-nf-call-arptables"

]

comment_lines {

$sysctl_comment_lines :

filename => "$sysctl_file"

}

# Add security sysctl values sysctl::conf

{

'vm.mmap_min_addr': value => '65536';

'kernel.modprobe': value => '/bin/false';

'kernel.kptr_restrict': value => '1';

'net.ipv6.conf.all.disable_ipv6': value => '1';

}

# Deny kernel read to others users case $::kernel_security_rights {

'0': {

exec {'chmod_kernel':

command => 'chmod o-r /boot/{vmlinuz,System.map}-*'

}

}

'1' : {

notice("Kernel files have security rights")

}

}

# Change opened file descriptor value and avoid fork bomb by limiting number of process limits_conf {

"open_fd": domain => '*', type => '-', item => nofile, value => 2048;

"fork_bomb_soft": domain => '@users', type => soft, item => nproc, value => 200;

"fork_bomb_hard": domain => '@users', type => hard, item => nproc, value => 300;

}

} |

Quelques explications s'imposent :

- Manage Root passwords : On définit le mot de passe root souhaité sous forme md5 et sha1. En fonction de ce qu'il y aura de configuré sur la machine, il configurera le mot de passe souhaité. Pour cette détection j'utilise un facter (passwd_algorithm.rb)

- Enable auditd service : on s'assure que le service auditd démarrera bien au boot et tourne actuellement

- Comment unwanted sysctl lines : nous demandons que certaines lignes présentes dans sysctl soient commentées si elles existent

- Add security sysctl values : nous ajoutons des règles sysctl, ainsi que leur assignons une valeur

- Deny kernel read to others users : j'ai créer ici un facter, qui permet de vérifier les droits des fichiers kernel (kernel_rights.rb)